Создание robots txt: полный гайд о файле

Написала: Карпова Ксения

Проверил: Орлов Андрей

Дата публикации: 01.09.2023

Дата обновления: 31.01.2024

Содержание:

1. Что такое robots.txt

2. Зачем Robots.txt нужен для SEO

3. Где находится и как создать

4. Настройка и редактирование

5. Как проверить Robots.txt

6. Правильный robots для WordPress

7. Правильный robots для Joomla

8. Правильный robots для Tilda

9. Правильный robots для Bitrix

10. Заключение

11. Вопросы и ответы

Видеообзор:

Robots.txt - это текстовый файл, который сообщает поисковым роботам (краулерам), какие страницы вашего сайта они могут индексировать, а какие нет. Он позволяет вебмастерам контролировать процесс индексации веб-сайта, чтобы поисковые системы не индексировали конфиденциальную информацию или страницы с техническим содержимым.

Корректный robots.txt может оказать значительное влияние на продвижение сайта и его позиции в поисковых системах. В этой статье мы подробно разберем, что такое robots.txt, зачем он нужен для SEO, где находится и как создавать такой файл. Рассмотрим основные директивы - User-Agent, Disallow, Allow, Crawl-delay и другие. Узнаете, как правильно проверить файл на ошибки и настроить для популярных CMS - WordPress, Joomla, Bitrix и Tilda.

1. Что такое robots.txt

В нем Web-мастер указывает правила для краулеров при индексации страниц сайта. Этот файл должен быть размещен в корневой директории сайта. Все краулеры, которые придерживаются стандартов (в частности, Googlebot и Яндекс), обращаются к данному файлу при попытке проиндексировать страницы ресурса.

Robots содержит специальные директивы, с помощью которых можно:

- запретить индексацию определенных страниц или каталогов;

- разрешить индексацию ранее закрытых страниц;

- указать время задержки между запросами роботов к серверу;

- прописать путь к файлу карты сайта Sitemap.

Используя robots.txt правильно, вебмастера могут улучшить восприятие ресурса поисковыми системами, повысить релевантность индексируемых страниц, оптимизировать нагрузку на сервер.

2. Зачем Robots.txt нужен для SEO

Он играет важную роль в продвижении сайта и оптимизации для поисковых систем.

Грамотное составление этого файла позволяет решить сразу несколько задач:

- Ограничить доступ к конфиденциальным, служебным и дублирующим страницам. Их индексация не только бесполезна, но и вредна. Это могут быть раздел администратора, корзина интернет-магазина, страницы с одинаковым контентом и т. п. Закрыв их от индексации, мы экономим квоту поисковых систем и сохраняем нужный вес для уникального контента.

- Задать оптимальную скорость индексации с помощью директивы Crawl-Delay. Если не ограничивать скорость, робот может запросить сотни страниц в секунду, создав ненужную нагрузку на сервер. Поэтому лучше явно указать время задержки между запросами.

- Предотвратить блокировку сайта из-за переиндексации. Если по каким-то причинам роботы начали слишком активно сканировать ресурс, в первую очередь пострадает сервер. В результате сайт может быть заблокирован за DDOS-атаку. Чтобы этого избежать, с помощью Robots.txt регулируем интенсивность индексации.

- Указать краулерам путь к Sitemap. XML карта сайта позволяет быстрее проиндексировать новые и обновленные страницы. Ее размещение важно для свежего контента - новостей, статей, товаров интернет-магазина.

- Распределить крайулинговый бюджет. Это ограничение на максимальное количество страниц, которые поисковый краулер может запросить с сайта за определенный период. Этот показатель зависит от мощностей и настроек самого поисковика. При его исчерпании индексация сайта приостанавливается до "обнуления счётчика". Грамотная настройка помогает экономить краулинговый бюджет и избегать блокировок сайта.

Грамотно настроенный Robots.txt - это первый шаг в технической оптимизации. Он позволяет существенно улучшить восприятие и индексацию сайта в Google и Яндекс.

3. Где находится и как создать

Он должен располагаться в корневой директории сайта. Это может быть:

- example.com/robots.txt - для домена

- example.com/blog/robots.txt - для каталога /blog

- example.com/shop/robots.txt - для папки интернет-магазина

Поисковые роботы ищут его именно по этим адресам.

Чтобы его создать, достаточно сделать простой текстовый документ без форматирования. Можно воспользоваться почти любым текстовым редактором, например, блокнотом на Windows или аналогичными приложениями. Созданный файл также можно редактировать стандартными приложениями для работы с текстом, главное - сохранять последовательность директив.

Рекомендуется сохранять в кодировке UTF-8 с расширением txt. Кодировку можно указать в начале документа.

Также файл можно создать через FTP, разместив простой текстовик в корне сайта:

- Загрузиться на хостинг по FTP.

- Создать новый документ robots.txt.

- Ввести нужные директивы (User-agent, Disallow, Allow, Sitemap и т.д.).

- Сохранить в кодировке UTF-8.

- Загрузить robots в корень сайта.

Готово! Теперь этот файл будут учитывать все поисковые роботы при сканировании ресурса.

4. Настройка и редактирование

Для изменения или добавления новых директив достаточно открыть файл роботов, например, через FTP в программах FileZilla, Total Commander, WinSCP или аналогичных. Затем вносим нужные правки обычным copy-paste или вручную.

После редактирования нужна загрузка на сервер для применения изменений. Либо можно воспользоваться функцией "FTP-синхронизации", которая автоматически заменит старую версию при сохранении отредактированного документа. Также учитывайте, что максимальный размер файла robots.txt не должен превышать 500 КБ. Ниже рассмотрим некоторые параметры.

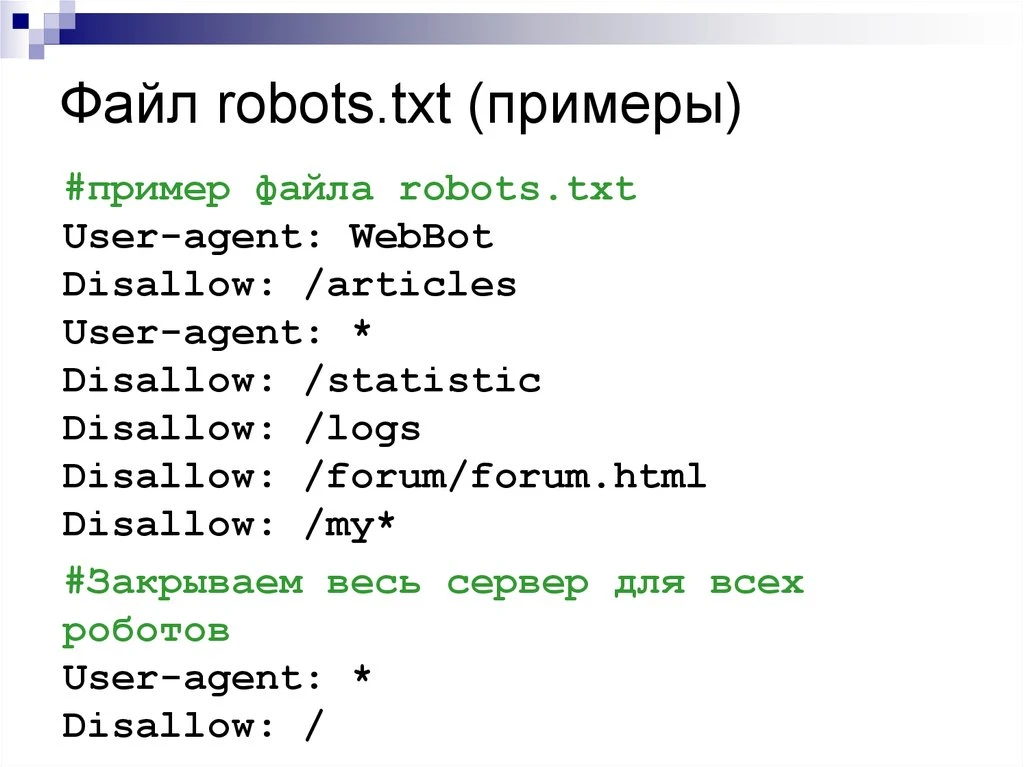

User-Agent

Директива User-agent позволяет применять правила отдельно для разных поисковых роботов. Как правило, все файлы роботов начинаются с этой настройки.

Например, с помощью User-Agent можно задать одни ограничения для Googlebot, другие - для Яндексбот. Синтаксис:

User-agent: Googlebot

Disallow: /tmp/

User-agent: Yandex

Disallow: /texts/

В примере для Google закрыта папка /tmp/, а для Яндекс - каталог /texts/.

Также есть возможность указать через User-Agent общее правило для всех ботов сразу:

User-agent: *

Disallow: /private.php

Звездочка означает, что запрет распространяется на любых поисковых роботов без исключения.

Таким образом с помощью User-agent реализуется гибкое управление доступом к разным частям сайта.

Disallow

Директива Disallow закрывает краулерам доступ к указанным страницам и каталогам на сайте.

Disallow позволяет исключить и закрыть к индексированию:

- конфиденциальные разделы (корзина, личный кабинет пользователя);

- страницы дубли;

- служебные файлы (xml, log);

- страницы, не предназначенные для индексации.

Прописывайте Disallow после директивы User-agent для привязки правил к конкретному боту.

Формат записи:

Disallow: /folder1/

Disallow: /texts/tmp.html

Disallow: /texts/tmp2.html

Disallow: /texts/tmp3.html

Disallow: /texts/tmp4.html

Disallow: /texts/tmp5.html

Disallow: /texts/tmp6.html

С помощью Disallow можно значительно оптимизировать роботизированный доступ, повысить релевантность индексируемых страниц и снизить нагрузку на сервер.

Allow

Директива Allow, наоборот, разрешает индексацию для поисковых роботов.

Формат:

Disallow: /images/

Allow: /images/preview.jpg

Сначала мы запретили индексировать директорию /images/. Но с помощью Allow мы указали, что preview.jpg нужно включить в индекс.

Другой пример:

User-agent: *

Disallow: /texts/

Allow: /texts/arrivals.html

Здесь мы запрещаем индексировать каталог /texts/, но страницу /arrivals.html нужно проиндексировать.

При указании путей директив Allow и Disallow можно использовать символы * и $, чтобы задавать определенные регулярные выражения. Таким образом используя Disallow и Allow можно точно настроить доступ для роботов на сайте, разрешив индексацию только нужных страниц.

Crawl-delay (устаревшая директива)

Важно! С 22 февраля 2018 года Яндекс перестал учитывать директиву Crawl-delay. Google также не поддерживает эту директиву.

Ранее директива Crawl-delay использовалась для указания интервала между запросами робота к серверу в секундах. Синтаксис был следующим:

User-agent: *

Crawl-delay: 10

Современные альтернативы:

- Для Яндекса: используйте настройки скорости обхода в Яндекс.Вебмастере в разделе "Индексирование — Скорость обхода"

- Для Google: поисковый робот автоматически регулирует скорость обхода в зависимости от реакции сервера

Хотя некоторые другие поисковые системы (например, Bing) все еще могут поддерживать Crawl-delay, для основных поисковиков (Google и Яндекс) эта директива неактуальна.

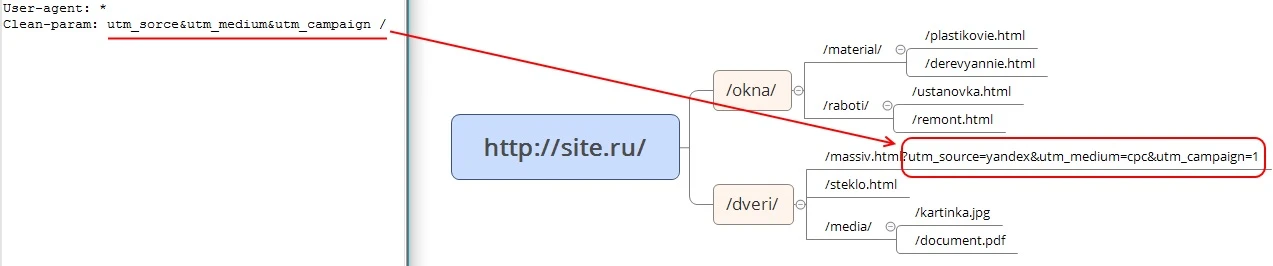

Clean-param (только для Яндекса)

Директива Clean-param специфична для Яндекса и не поддерживается Google. Она указывает поисковому роботу Яндекса игнорировать определенные GET-параметры в URL страниц сайта.

Например, есть адрес:

<a href="http://site.ru/page.php?utm_source=email">http://site.ru/page.php?utm_source=email</a>

С помощью Clean-param он будет обработан так:

<a href="http://site.ru/page.php">http://site.ru/page.php</a>

Важно: Использование Clean-param в robots.txt может вызывать предупреждения в Google Search Console, поскольку Google не распознает эту директиву. Это нормально и не влияет на индексацию Google.

Применяется для всего сайта:

User-agent: Yandex

Clean-param: utm_source&utm_medium&utm_campaign

То есть робот проиндексирует только основной адрес страницы, игнорируя GET-параметры.

Это бывает полезно, чтобы избежать дублирования в индексе и сэкономить квоту за счет страниц с параметрами.

Применяется для всего сайта:

User-agent: *

Clean-param: on

По умолчанию параметр выключен, поэтому его нужно явно указывать.

Host (полностью устаревшая)

Директива Host полностью устарела и не поддерживается ни Google, ни Яндекс с 2018 года.

Ранее в Яндексе она использовалась для указания канонического домена сайта:

Host: <a href="https://site.ru">https://site.ru</a>

Современная замена: используйте 301-редиректы для настройки канонического домена. Важно, чтобы на всех не главных зеркалах сайта стоял 301-й постраничный редирект на соответствующие страницы главного зеркала.

Комментарии в robots.txt

Robots.txt поддерживает комментарии, которые игнорируются роботами, но читаются человеком. Комментарии удобно добавлять для пояснения назначения директив. Вот пример кода:

# Запрет индексации папки с изображениями

User-agent: *

Disallow: /images/

#Ограничение скорости для Яндекс

User-agent: Yandex

Crawl-delay: 10

Так структура и назначение разных правил становится понятна при визуальном осмотре.

Комментарии полезны в работе особенно при коллективной разработке сайта - веб-мастер сразу видит пояснения к тем или иным ограничениям для роботов.

Карта сайта — Sitemap.xml

Чтобы указать поисковым роботам путь к XML-карте сайта со всеми ссылками, используется следующий код:

Sitemap: http://site.ru/sitemap.xml

или:

Sitemap: sitemap.xml

Это нужно для того, чтобы роботы могли быстрее обнаруживать и индексировать новые и обновленные страницы.

Преимущества указания XML-карты:

- более быстрая индексация нового контента;

- возможность в одном файле описать большое количество страниц;

- гибкость настройки приоритетов индексации разных разделов.

Поэтому на больших сайтах настоятельно рекомендуется добавлять путь к sitemap.xml в robots.txt как для Яндекс, так и для Google.

Подпишись на наш Telegram-канал и получи бесплатный чек-лист по базовой SEO оптимизации

Ещё больше полезной информации о продвижении в интернете и успешных кейсах

5. Как проверить Robots.txt

Правильное составление и проверка robots.txt - важная часть оптимизации сайта. От функционирования этого файла напрямую зависит процесс индексации страниц поисковыми роботами. Поэтому вебмастеру нужно сделать этот файл правильно и проверить его.

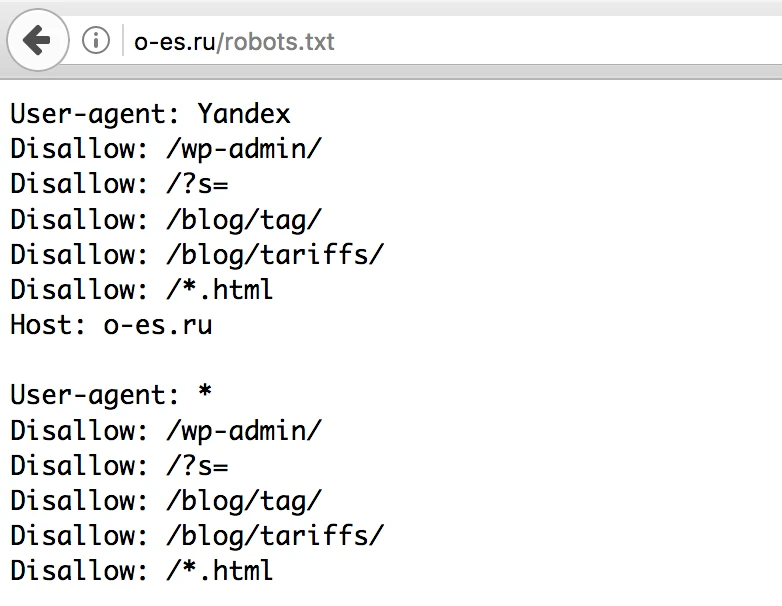

Как проверить robots.txt на сайте

Один из простых способов провести анализ - загрузить файл robots.txt со своего сайта и визуально осмотреть его содержимое.

Вот краткая инструкция:

- Открыть браузер, ввести в поле адресной строки: yoursite.com/robots.txt

- Нажать Enter, откроется содержимое файла

- Проверить наличие всех нужных директив, отсутствие явных ошибок.

- Убедиться, что закрыты для индексации ненужные страницы, такие как приватный раздел админки, служебные каталоги, дублирующий контент.

- Проверить, что файл составлен правильно, нет лишних запятых, пробелов.

Этот способ подходит для быстрой визуальной проверки файла прямо на работающем сайте.

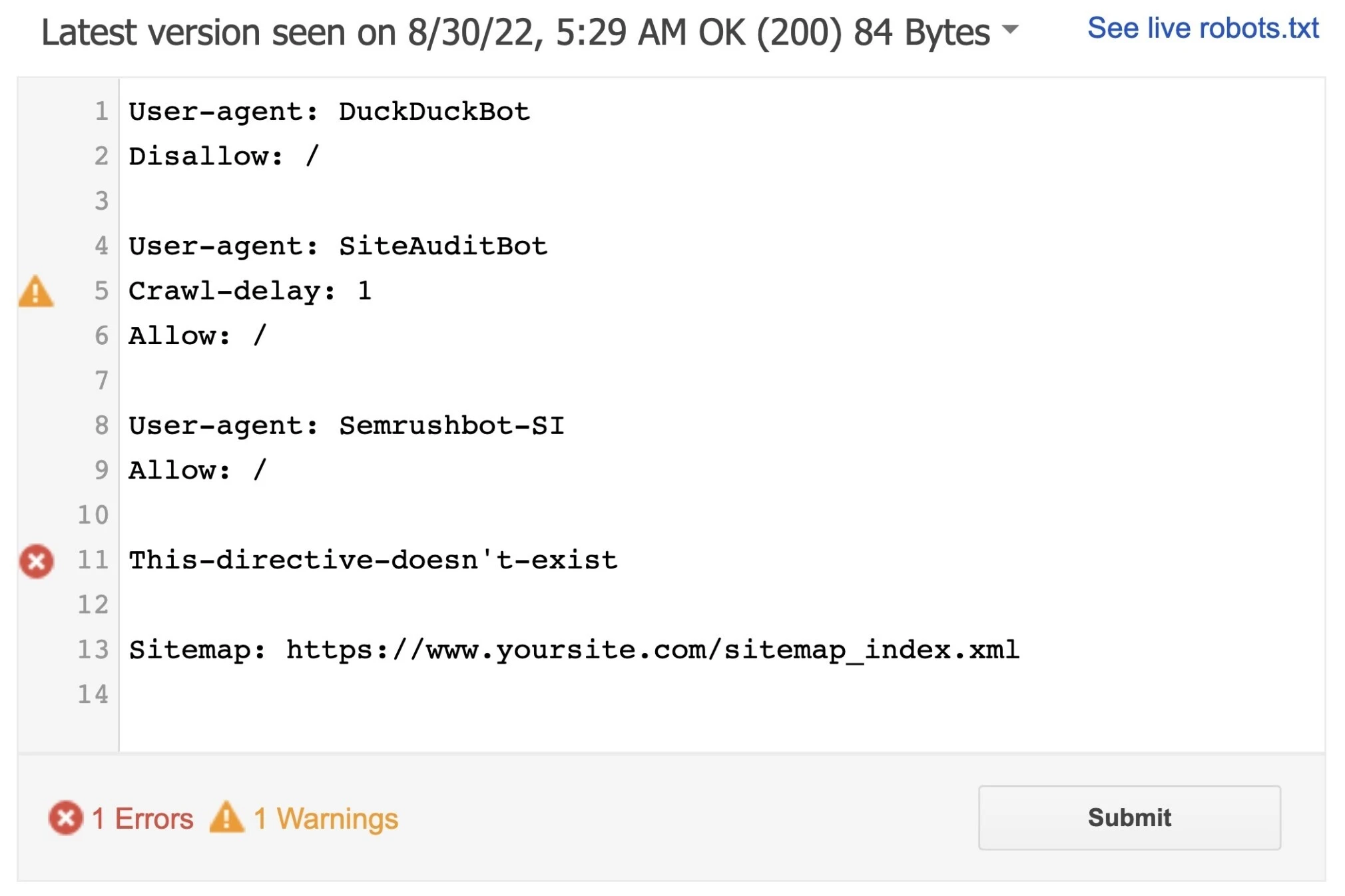

Как проверять robots.txt через консоли вебмастера гугл и яндекс

Для более глубокой автоматизированной проверки корректности robots.txt следует воспользоваться специальными инструментами в панелях вебмастера. Существует два варианта.

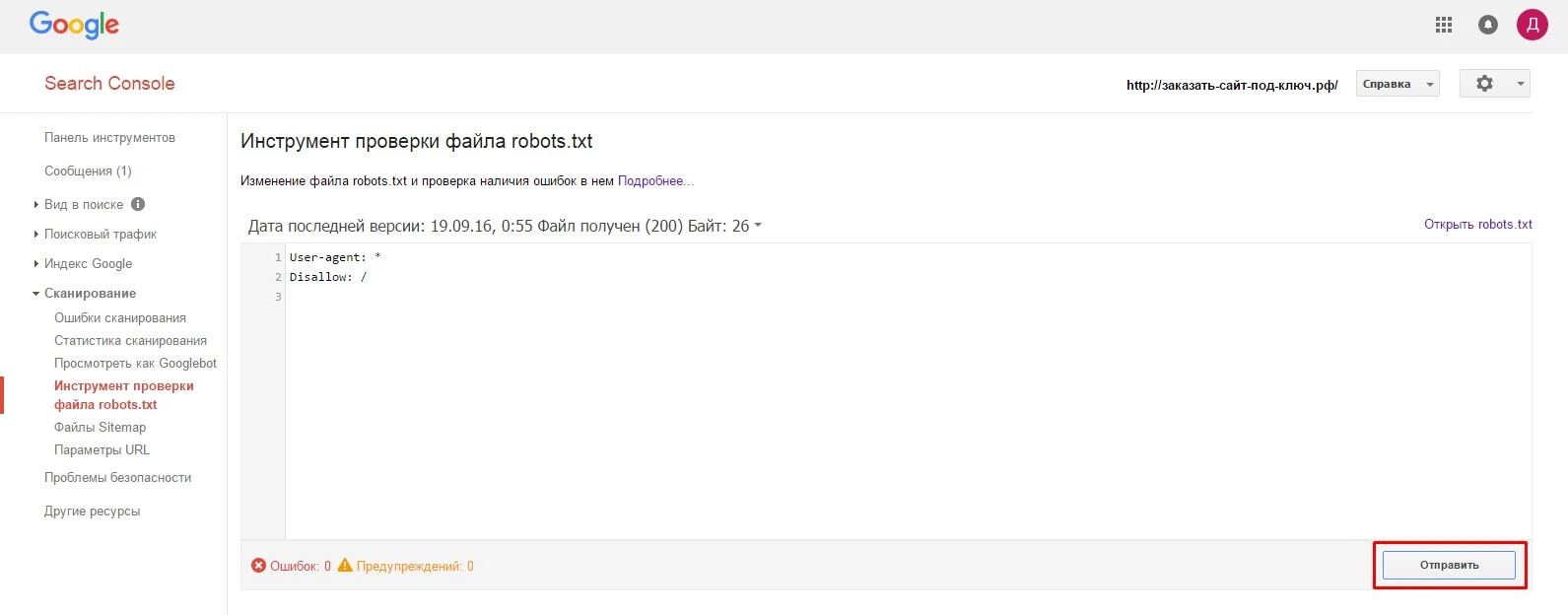

Google Search Console

Google предоставляет инструмент "Проверка robots.txt" в Search Console. Чтобы им воспользоваться нужно зайти по адресу https://www.google.com/webmasters/tools/robots-testing-tool

Это позволит увидеть список доступных и заблокированных страниц, а также получить предупреждения о потенциальных ошибках.

Яндекс Вебмастер

Аналогичный по назначению сервис есть в Яндекс Вебмастере - https://webmaster.yandex.ru/tools/robotstxt/. После проверки будет виден статус файла, список заблокированных страниц и ошибок при их наличии.

Рекомендуем пользоваться этими сервисами, чтобы посмотреть, какие неточности есть в файле.

Частые ошибки Robots.txt

Одна из распространенных ошибок - блокировка целого домена или корневой папки. Например:

User-agent: *

Disallow: /

В этом случае роботам запрещен доступ ко всему сайту!

Поисковые системы перестанут индексировать страницы, позиции упадут. А через некоторое время возможно полное исключение ресурса из поиска, если он перестанет отдавать ответы.

Поэтому вместо полной блокировки лучше указать конкретные разделы:

Disallow: /admin/

Disallow: /tmp/

Также частая ошибка - дублирование домена с www и без:

Disallow: http://site.ru/

Disallow: http://www.site.ru/

В такой ситуации лучше использовать директиву Host.

Еще одна частая ошибка - написание названий директив в верхнем регистре букв, например, DISALLOW вместо Disallow. Писать нужно с соблюдением регистра. Важно следить за правильностью robots.txt и своевременно исправлять возможные недочеты.

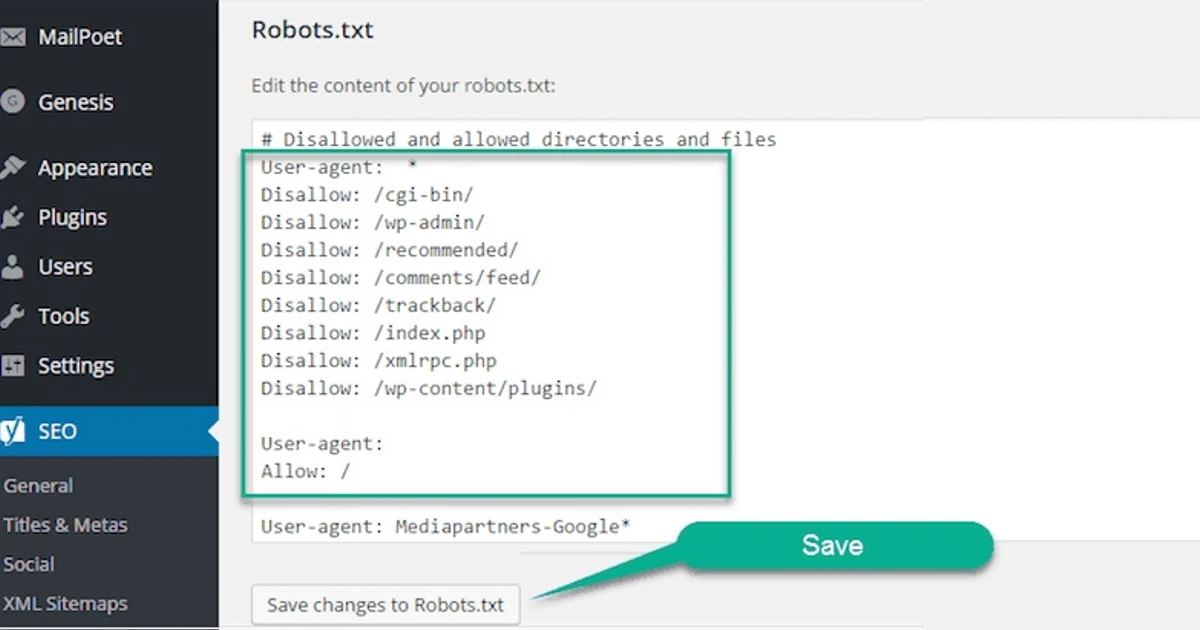

6. Правильный файл robots для WordPress

WordPress - одна из самых популярных CMS для создания сайтов. У нее есть некоторые особенности при работе с robots.txt.

Актуальный robots.txt для WordPress (2025):

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Allow: /wp-content/uploads/

Allow: /wp-admin/admin-ajax.php

# Для Яндекса можно дополнительно указать

User-agent: Yandex

Clean-param: utm_source&utm_medium&utm_campaign

Sitemap: <a href="https://yoursite.com/sitemap.xml">https://yoursite.com/sitemap.xml</a>

Обратите внимание: Clean-param используется только для Яндекса и может вызывать предупреждения в Google Search Console - это нормально.

Рассмотрим оптимальную конфигурацию для WordPress:

- По умолчанию в WordPress уже есть этот файл, который блокирует доступ к служебной директории /wp-admin/. Это раздел администратора, его не нужно индексировать.

- Нужно закрыть для сканирования папки кеша и компиляции шаблонов - /wp-content/cache/, /wp-content/uploads/. Также лучше заблокировать XML-карты старых версий /sitemap_index.xml. Еще доступ нужно закрыть для всех баз и ссылок с utm-метками.

- Рекомендуется установить задержку между запросами роботов к серверу. Оптимальный интервал для WordPress - от 10 до 15 секунд.

- Полезно указать путь к текущей XML-карте всего сайта, чтобы поисковики могли быстрее обнаруживать новые материалы.

- Если используются плагины кеширования, нужно закрыть динамические html-страницы: /index.html, /page-*.html.

Грамотная настройка robots.txt ускорит индексацию именно уникального контента и позволит WordPress-сайту занимать высокие позиции в выдаче.

7. Правильный файл robots для Joomla

Joomla - популярный инструмент для создания сайтов средней сложности.

Эта CMS также имеет свои нюансы в настройке robots.txt:

- В Joomla по умолчанию нет файла robots, поэтому его нужно создать вручную в корневой папке сайта.

- Обязательно стоит закрыть папку администратора /administrator/, чтобы скрыть ее от индексации.

- Также следует заблокировать доступ к временным техническим папкам: /cache/, /logs/, /tmp/

- Полезно указать Crawl Delay - задержку между запросами робота. Для среднего Joomla-проекта достаточно 10 секунд.

- Запросить проиндексировать главную страницу и карту сайта.

Следуя этим рекомендациям, вы настроите корректную индексацию сайта на Joomla. Это улучшит видимость именно уникального качественного контента в поисковой выдаче Google и Яндекса.

8. Правильный файл robots для Tilda

Конструктор Tilda автоматически генерирует этот файл при создании сайта. В нем автоматом закрываются служебные разделы, не предназначенные для индексации. Поэтому вручную отредактировать или добавить какие-то правила скорее всего не потребуется.

9. Правильный файл robots для Bitrix

В системе управления сайтами Bitrix также изначально есть этот файл. Но в нем закрываются только основные служебные разделы.

Для полноценной настройки под SEO придется внести дополнения вручную:

- Заблокировать папки кеша, файловых скачек.

- Добавить информацию о карте сайта sitemap.xml.

- Разрешить для индексации скрипты JS и CSS.

- Установить задержки для роботов Яндекс и Google.

После этих доработок robots будет полностью готов для корректного сканирования страниц сайта на Bitrix.

Последние изменения в поддержке robots.txt (2024-2025)

В октябре 2024 года Google внес важные изменения в политику поддержки robots.txt, которые критически важно учитывать при настройке файла.

Официально поддерживаемые Google директивы:

- User-agent

- Allow

- Disallow

- Sitemap

Все остальные директивы теперь официально игнорируются Google. Это означает, что такие популярные ранее директивы как Crawl-delay, Host и другие не будут обрабатываться поисковым роботом.

Различия в поддержке между Google и Яндекс:

| Директива | Яндекс | Примечание | |

|---|---|---|---|

| User-agent | ✅ | ✅ | Основная директива |

| Allow | ✅ | ✅ | Разрешение доступа |

| Disallow | ✅ | ✅ | Запрет доступа |

| Sitemap | ✅ | ✅ | Указание карты сайта |

| Crawl-delay | ❌ | ❌ | Не поддерживается с 2018 года |

| Clean-param | ❌ | ✅ | Только для Яндекса |

| Host | ❌ | ❌ | Устарела с 2018 года |

Рекомендации:

- Используйте только поддерживаемые директивы для обеспечения корректной работы с Google

- Для российского рынка учитывайте особенности Яндекса при использовании Clean-param

- Регулярно аудируйте robots.txt на предмет устаревших директив

10. Заключение

Настройка robots.txt является важным этапом технической оптимизации сайта для поисковиков. Грамотный подход позволяет улучшить индексацию, снизить нагрузку на сервер и избежать других проблем, ускорить обнаружение нового контента. В зависимости от платформы и CMS могут быть свои нюансы. Но следуя основным принципам и рекомендациям, можно добиться эффективной работы этого важного SEO-файла.

Подпишись на наш Telegram-канал и получи бесплатный чек-лист по базовой SEO оптимизации

Ещё больше полезной информации о продвижении в интернете и успешных кейсах

11. Вопросы и ответы

Можно ли временно закрыть сайт на реконструкцию через robots.txt?

Да, при крупных обновлениях или переносе на новую платформу так поступают. Главное потом не забыть удалить временные ограничения в robots.txt, иначе сайт так и останется "закрытым" для поисковиков.

Как быстро изменения в robots.txt вступят в силу?

Обычно роботы перечитывают этот файл каждые несколько часов. Но если загрузить свежую версию через инструменты для вебмастеров Яндекс или Google, изменения применят почти мгновенно - за считанные минуты, максимум 1-2 часа.

Можно ли поломать сайт неправильным robots.txt?

Сломать" технически - вряд ли. Но неправильные настройки этого файла могут привести к падению позиций, удалению сайта из поиска или другим негативным последствиям. Поэтому при редактировании нужна аккуратность и проверка. Лучше обратиться к опытному специалисту, если вы не уверены в своих силах.

Что будет если оставить файл робота пустым?

Пустой файл роботов - полная свобода для поисковых систем. На вашем сайте будет индексироваться всё, что сможет найти и увидеть бот. Это негативно влияет на сайт.

Статья написана экспертом Карпова Ксения

Копирайтер Skilful Web Developers

- Больше 3 лет занимается написанием и продвижением статей

- +30 тематик изучено, проработано и выведено в ТОП

- +1000 статей опубликованы на сайтах, каналах и других источниках

Контент проверил эксперт Орлов Андрей

Руководитель проектов по продвижению

- Больше 5 лет занимается продвижением в интернете

- +10 проектов выведены в ТОП с нуля

- +30 компаний достигли лидирующих позиций в поисковой выдаче под его руководством